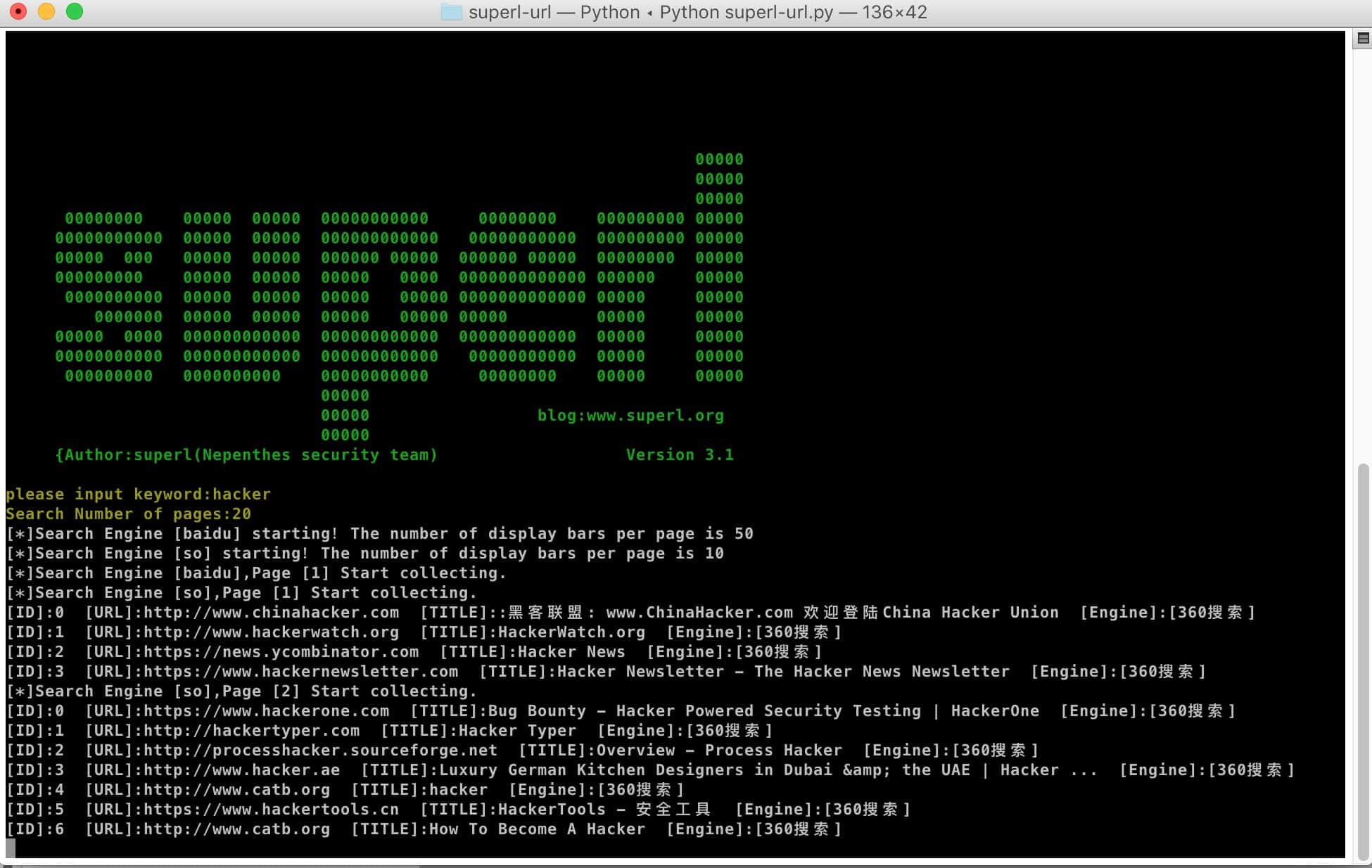

超级关键词URL采集工具:superl-url

- 发表于

- 安全工具

superl-url 关键词URL采集

- 根据关键词,对搜索引擎内容检索结果的网址内容进行采集的一款轻量级软程序。

- 程序主要运用于安全渗透测试项目,以及批量评估各类CMS系统0DAY的影响程度,同时也是批量采集自己获取感兴趣的网站的一个小程序~~

- 可自动从搜索引擎采集相关网站的真实地址与标题等信息,可保存为文件,自动去除重复URL。同时,也可以自定义忽略多条域名。

程序特色

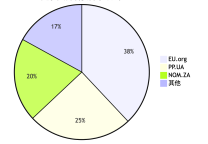

- 支持同时采集多个搜索引擎(已内置了百度,搜狗,360),结构模块化,很方便进行扩展,可以无限添加。

- 获取到的是搜索引擎的搜索结果的真实URL地址

- 跨平台,采用Python开发,所有代码完整开源.并且无捆绑后门风险,更新方便。网上大部分URL采集软件为WINDOWS下的可执行文件,并且很多都在搜索引擎更新后无法正常使用。

- 强大的过滤功能。可过滤多种顶级域名,可过滤指定标题中包含某关键子的URL,比如搜索结果中过滤属于youku.com的子域名URL。支持TXT配置过滤。

- 可自动去除重复URL

- 可灵活的通过配置文件自定义要保存的结果格式。比如只输出带参数的原始真实URL,或者只输出域名,或者同时输出标题,搜索引擎名称。

- 可灵活的开启与关闭参与采集的搜索引擎,比如只想使用百度,就把其他搜索引擎参数设置为False即可。

- 同时兼容python3和python2版本运行!良心开源小产品啊~~~

- 可分别自定义不同搜索引擎每页显示数量(如果搜索引擎自身支持的话)

- 支持多进程同时采集,每个搜索引擎一个进程

- 可自定义每页采集时间间隔,防止被屏蔽

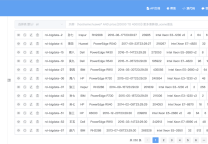

- 实时显示采集到的网页的【真实URL】以及【标题】。前面的【ID】对应的是当前页搜索引擎结果的第X条数据

- 保存类型可自定义,目前支持保存为本地txt,以及写入远程MYSQL数据库!

superl-url安装与使用

|

1 |

git clone https://github.com/super-l/superl-url.git |

安装依赖

- python3:

pip install ConfigParserpip install tldextract - Python2:

pip install tldextractpip install -i https://pypi.tuna.tsinghua.edu.cn/simple configparser - 如果提示模块不存在,则根据提示进行安装!

使用说明

- 如果要采集关键词为“hacker”的相关网站,采集搜索结果的前3页,则输入如下:

- please input keyword:hacker

- Search Number of pages:3

配置文件说明 config.cfg

| 节点 | 参数 | 示例值 | 说明 |

|---|---|---|---|

| global | save_type | mysql | 保存类型 可选择file或者mysql 如果是file则保存为本地txt |

| global | sleep_time | 1 | 每次搜索处理完一页后的等待时间,防止太频繁被搜索引擎屏蔽 |

| url | url_type | realurl | 保存文件txt里面显示的url类型。realurl=真实网站地址 baseurl=原始搜索引擎地址 urlparam=带参数的真实网站地址 |

| filter | filter_status | True | 是否开启过滤器,如果开启,则过滤域名和标题都不生效 |

| filter | filter_domain | True | 是否过滤域名 |

| filter | filter_title | True | 是否过滤标题 |

| log | write_title | True | 是否显示标题 |

| log | write_name | True | 是否显示搜索引擎名称 |

| engine | baidu | True | 百度搜索引擎模块是否开启 |

| engine | sougou | True | 搜狗模块是否开启 |

| engine | so | False | 搜搜模块是否开启 (搜搜现在抓取不到了) |

| pagesize | baidu_pagesize | 50 | 每页条数 |

| pagesize | sougou_pagesize | 50 | 每页条数 |

| pagesize | so_pagesize | 10 | 每页条数 |

| mysql | host | 127.0.0.1 | 如果保存类型为Mysql,则此节点必须配置正确 |

| mysql | port | 3306 | 端口 |

| mysql | user | root | 用户名 |

| mysql | password | root | 密码 |

| mysql | database | superldb | 数据库名称 |

| mysql | table | search_data | 表名称 |

| file | save_pathdir | result | 如果保存类型为file,则这里设置的是保存的路径,当前为程序根目录的result文件夹 |

| plugin | pr | True | 预留的插件功能,暂时不支持 |

数据库创建表sql语句

|

1 2 3 4 5 6 7 8 9 10 11 |

CREATE TABLE `search_data` ( `id` int(11) unsigned NOT NULL AUTO_INCREMENT, `engine` varchar(20) NOT NULL DEFAULT '', `keyword` varchar(100) NOT NULL DEFAULT '', `baseurl` varchar(255) NOT NULL DEFAULT '', `realurl` varchar(255) NOT NULL DEFAULT '', `urlparam` varchar(255) NOT NULL DEFAULT '', `webtitle` varchar(255) NOT NULL DEFAULT '', `create_time` int(10) NOT NULL, PRIMARY KEY (`id`) ) ENGINE=MyISAM AUTO_INCREMENT=395 DEFAULT CHARSET=utf8; |

原文连接:超级关键词URL采集工具:superl-url

所有媒体,可在保留署名、

原文连接的情况下转载,若非则不得使用我方内容。